Wenn die Mitarbeiter von Leadec zu industriellen Anlagen gerufen werden, hat das häufig den Charme eines Feuerwehreinsatzes. In der Regel sind die Ursachen sporadische Unterbrechungen der Produktion oder gar ein kompletter Stillstand wegen Störungen in der Kommunikation im Anlagennetzwerk oder Feldbus. In anderen Fällen geht es um die Abnahme von neuen Anlagen oder die Anpassung der Kommunikation.

Es gibt jedoch auch noch andere Gründe: „Kürzlich hatten wir den Auftrag, ein Netzwerk auf Netzlast, Auslastungsgrad der Netzlastklasse, Jitter und Lost-Telegramme zu untersuchen“, berichtet Hans-Ludwig Göhringer, Netzwerk- und Feldbusexperte bei Leadec. „Auf den ersten Blick hat das wie eine Routine-Arbeit ausgesehen. Dann hat sich jedoch gezeigt, dass wir mitten in einem Projekt zu den Themen künstliche Intelligenz und maschinellem Lernen gelandet sind.“

Daten, Daten, Daten

Vereinfacht gesagt erkennen KI-Systeme in großen Datenmengen wiederkehrende Muster. Das funktioniert nur richtig, wenn die Quantität und die Qualität der Datensätze stimmen. Maschinelles Lernen für die prädiktive Instandhaltung oder zur Verbesserung von Produktionsprozessen funktioniert nur dann richtig, wenn die eingesetzten Methoden und Algorithmen aus möglichst großen Datenmengen lernen.

Im Produktionsumfeld erhält man die relevanten Daten von den Steuerungen, Sensoren und von Aktoren, die verschiedene Aktualwerte und Diagnosedaten liefern. Je nach KI-Anwendung kann eine Erweiterung um weitere Sensoren oder Systeme zur Bildverarbeitung notwendig sein. Durch den Einsatz von selbstlernenden Modellen ist es z.B. möglich, dass ein System Fehlermuster in Echtzeit erkennt und damit Qualitätsmängel effektiv vermeidet.

Als Rückgrat in den Maschinen und Anlagen spielen industrielle Netzwerke wie Profinet eine entscheidende Rolle. Neben der Datenkommunikation zwischen den Steuerungskomponenten, die für das Funktionieren der Anlage an sich notwendig ist, wird nun zusätzliche Bandbreite für die Erfassung der KI-Datenbasis benötigt. Nebenbei sei noch erwähnt, dass hier häufig auch eine Cloud-Anbindung erfolgt. Das führt hinsichtlich der Security-Themen Zugriffssicherheit und Datenschutz zu weiteren Herausforderungen, die gelöst werden müssen. Darauf soll an dieser Stelle nicht näher eingegangen werden.

Netzlast des Anlagennetzwerks

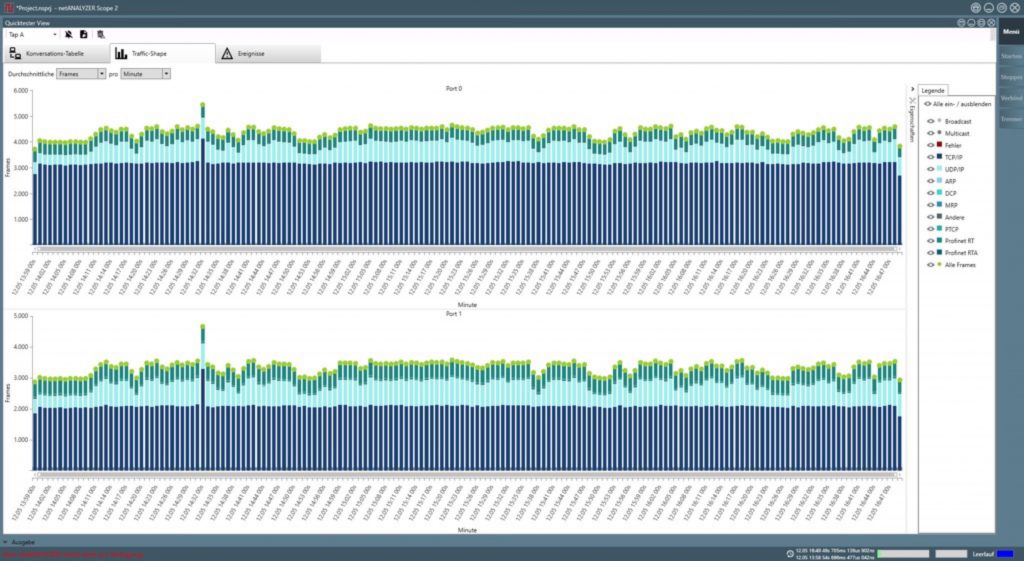

Im bereits angesprochenen Anlagennetzwerk ging es darum, welche Reserven in der Profinet-Kommunikation bestehen bzw. wie sich die zusätzliche, von der KI verursachte, Kommunikationslast auf den Datenverkehr in der Anlage auswirkt. Laut der Profinet-Nutzerorganisation PNO soll die Netzlast im Betrieb des Netzwerkes an wichtigen Punkten bestimmt werden. Am wichtigsten sind die Knotenpunkte, da hier die höchste Konzentration der Datenströme zu erwarten ist. Das ist in der Regel die Netzwerkverbindung zur SPS. Bei Multi-SPS-Anwendungen sollte die Netzlast an jeder Steuerung erfasst und der Maximalwert dokumentiert werden. Die Grenzwerte für die zyklische Echtzeitkommunikation gibt die PNO in den Vorgaben der Profinet Planungsrichtlinie wie folgt an:

- 50 Prozent: Maßnahmen zur Verminderung der Netzlast müssen ergriffen werden

Aktualisierungszeiten

Die Aktualisierungszeiten haben einen wesentlichen Einfluss auf die Netzlast. Je kleiner die Aktualisierungszeiten sind, desto höher ist die übertragene Datenmenge pro Zeit und damit auch die Netzlast. Die Aktualisierungszeiten der Profinet-Geräte werden passend zur Zykluszeit der übergeordneten SPS festgelegt. Um die Netzlast zu reduzieren, kann überprüft werden, ob die Zykluszeit der SPS – und damit auch die Aktualisierungszeiten der Profinet-Teilnehmer – reduziert werden kann. Dabei muss jedoch beachtet werden, dass hier auch die Linientiefe eine Rolle spielt. Jeder Switch, der in die Kommunikationsstrecke eingefügt wird, führt zu einer bestimmten Verzögerung der Kommunikation. Die Anzahl der Switches zwischen SPS und den Profinet-Geräten wird Linie genannt. Je größer die Linie, desto mehr vergrößert sich die Verzögerung des Datentransfers.

Management-Telegramme

Bei der zu beurteilenden Anlage wurde eine deutliche Zunahme des Datenverkehrs zum Schichtende erkannt, als die gesammelten Daten in die Cloud übertragen wurden. An einer Messstelle wurde mitgeschrieben, welche Telegramme davon in die Anlage gelangen. Bei näherer Betrachtung dieser Telegramme wurde entdeckt, dass es sich um Broadcast- und Multicast-Telegramme handelt. Diese Telegrammtypen werden von jedem Profinet-Teilnehmer gelesen und bearbeitet. Das kostet in jedem Gerät wertvolle Rechenleistung.

ARP-Pakete (Address Resolution Protocol) werden beispielsweise als Broadcast durch die ganze Linie gesendet. Die Pakete müssen dabei von jedem (IP-basierten) Gerät beantwortet werden. Dies betrifft ebenfalls Profinet-Geräte, da die NRT-Kommunikation (Non-Realtime) auf UDP/IP-Ebene erfolgt. Wenn darunter der Telegrammverkehr zwischen Teilnehmer und Steuerung leidet, kann es zum Ausfall der Anlage führen.

Im Zuge der Untersuchungen hat sich herausgestellt, dass bei Installationen mit älteren Geräten, die nicht der Profinet-Spezifikation 2.3 entsprechen, ein erhöhtes Ausfallrisiko für die Kommunikation besteht. Deshalb ist es sehr wichtig, dass alle Profinet-Teilnehmer auf dem neuesten Softwarestand sind.

Das Thema KI ist im Prinzip so alt wie die Computertechnik selbst. In der Forschung gab es, zumindest in der Theorie, schon früh erste Erfolge. Doch beim Versuch der praktischen Umsetzung stellte sich schnell heraus, dass die Hardware nicht leistungsfähig genug war. Entsprechend verlor die KI-Forschung an Bedeutung. Fast 50 Jahre, ab 1965 gerechnet, galt das Mooresche Gesetz. Das besagt eine Verdoppelung der Transistoren je Flächeneinheit alle zwei Jahre. Unabhängig davon, dass sich die Halbleiterindustrie zwischenzeitlich den physikalischen Grenzen nähert, haben wir heute eine Technologie mit enormer Leistungsfähigkeit.

Heute spielt dabei nicht nur Big Data eine wichtige Rolle, sondern auch die Cloud. Erst damit ist eine entspannte KI-Modellierung möglich. Jedoch können sich Daten und Konzepte durch neue Erkenntnisse schnell und auch auf überraschende Weise ändern – nicht nur im industriellen Umfeld. Die ständige Herausforderung für ML-Anwendungen besteht darin, die Modelle auf dem neuesten Stand zu halten und die Zuverlässigkeit über die Zeit zu erhalten, um den versprochenen Wert zu generieren und zu erhalten.